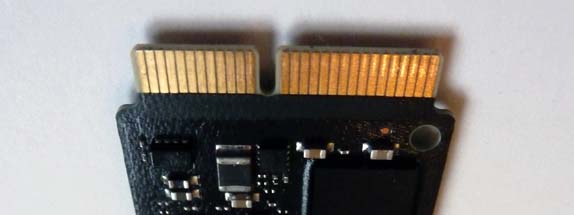

SSD-Laufwerke gelten als erste Empfehlung, um älteren Rechnern noch mal richtig Dampf zu machen. Auch in neuen Rechnern sorgen die kleinen Wunderwerke für erstaunliche Leistungszuwächse, und der Preis wird fast von Woche zu Woche interessanter. Der hat zwar noch lange nicht das Niveau der altgedienten feinmechanischen Festplatten erreicht, und in der maximalen Speicherkapazität gibt es noch große Unterschiede – aber die guten alten Festplatten wirken als letztes mechanisches Bauteil in einem aktuellen Rechner fast schon ein wenig angestaubt. Zeit also, sich etwas genauer mit den Vor- und Nachteilen aktueller SSD-Technik auseinanderzusetzen.

Noch immer sind viele Anwender der Meinung, SSDs seien robuster als Festplatten, sie würden viel seltener kaputtgehen und seien daher sicherer. An den Statistiken der großen Datenrettungsgesellschaften kann man aber sehen: das stimmt gar nicht ! Defekte SSDs kommen ebenso häufig vor wie defekte HDDs. Darüber hinaus ist eine Datenrettung von einer SSD nicht nur deutlich komplizierter, sondern auch erheblich teurer als von einem alten halbmechanischen Laufwerk.

Woran liegt das ?

Eine normale Festplatte ist nicht in der Lage, Daten zu löschen. Sie kann nur Daten schreiben. Wenn der Anwender eine Datei in den Papierkorb wirft und diesen dann entleert, wird die Datei nicht sofort von der Festplatte entfernt – es wird zunächst nur im Verzeichnis vermerkt, daß dieser Bereich der Platte wieder zur Verfügung steht. Die eigentlichen Daten bleiben so lange liegen, bis der Platz neu genutzt wird. Erst dann werden die alten Daten mit neuen Daten überschrieben.

„Löschen“ bedeutet bei einer Festplatte also nichts anderes als ein komplettes Überschreiben der freien Bereiche. Will man alle auf der Platte vorhandenen Dateien endgültig entfernen, müssen sie mit anderen Daten überschrieben werden. In der Regel werden Bitmuster, die z.B. Texte oder Bilder ergeben, dabei durch unverdächtige Nullen ersetzt. Wer eine komplette Platte schon einmal richtig gelöscht hat, weiß, wie lange so ein Vorgang dauert.

„Löschen“ bedeutet bei einer Festplatte also nichts anderes als ein komplettes Überschreiben der freien Bereiche. Will man alle auf der Platte vorhandenen Dateien endgültig entfernen, müssen sie mit anderen Daten überschrieben werden. In der Regel werden Bitmuster, die z.B. Texte oder Bilder ergeben, dabei durch unverdächtige Nullen ersetzt. Wer eine komplette Platte schon einmal richtig gelöscht hat, weiß, wie lange so ein Vorgang dauert.

Bei einer SSD ist das ganz anders. Eine SSD kann Daten löschen. Besser gesagt: sie muß sogar alte Daten löschen, bevor sie neue Daten aufnehmen kann. In der Praxis ist das ein massiver Nachteil, denn genau dieses Löschen kostet sehr viel Zeit, zumal nicht einfach genau die gewünschten Daten entfernt werden können, sondern immer ein relativ großer Bereich komplett geleert werden muß. Da in diesem Bereich oft auch noch benötigte Daten liegen, müssen diese zunächst an eine andere Stelle umkopiert werden. Erst dann kann der Bereich gelöscht und die ausgelagerten Daten wieder zurückbewegt werden.

Mit der Adressierung bei herkömmlichen Festplatten haben wir uns in diesem Artikel schon einmal ausführlich beschäftigt. Hier nochmal eine kurze Zusammenfassung:

Herkömmliche HDDs beherrschen immer noch zwei verschiedene Adressierungsarten. Eine davon ist die klare Ansprache eigentlich mechanischer Parameter wie zum Beispiel: 2. Platte, 24. Zylinder 8. Sektor.

Diese direkte Adressierung wurde irgendwann ersetzt durch eher logische Parameter. Der Fachbegriff dazu ist LBA für Logical Byte Adressing. War die Platte x MegaByte groß, ergab das bei 512 Byte-Sektoren: Gesamtgröße in Byte / 512 = die Anzahl der auf der Platte befindlichen Sektoren. Wie schon immer enthielt jeder Sektor 512 Byte.

Nach dieser Zählart waren die kleinen Zahlen der LBA ganz vorn auf der Platte, die großen ganz hinten. Ein großer Vorteil dieser Methode war es, daß die Plattenparameter dem Betriebssystem bzw. dem Filesystem nicht mehr bekannt sein mußten. Ob der Hersteller mehr Platten einsetzte oder die Anzahl der Zylinder oder Sektoren pro Zylinder veränderte, spielte keine Rolle mehr.

Wichtig war die feste Größe von 512 Byte für eine direkt adressierbare Datenmenge. Die Hersteller bildeten weitestgehend den herkömmlichen Aufbau weiterhin ab. Das mußte schon wegen der Startadressierung nach alter Adressierungart für die verschiedenen Betriebssysteme so sein.

Genau diese LBA-Adressierung ist für eine SSD heute extrem wichtig. Das Betriebssystem / Filesystem denkt weiterhin in den alten Strukturen – die SSD macht intern allerdings etwas völlig anderes !

Insbesondere zwei wichtige Eigenarten einer SSD müssen ständig berücksichtigt werden:

1. Löschvorgänge

Die Problematik des Löschens wurde oben schon angesprochen. Eine SSD muß Daten löschen, damit das volle Tempo bei einem Schreibvorgang zur Verfügung steht. Erschwert wird dieser Vorgang durch den internen Aufbau einer SSD.

Bei einer HDD ist der Sektor die kleinste Einheit. Die Entsprechung auf der SSD nennt sich Page und ist 4k groß – also exakt die Größe, die auch die aktuellen AF-Platten als kleinste Einheit adressieren. Diese Größe kann auch beschrieben werden, sowohl bei HDD wie auch bei SSD.

Auf der SSD werden jeweils 128 dieser Pages zu einem Block zusammengefaßt, und während eine HDD jeden einzelnen Sektor direkt überschreiben kann, muss die SSD den Platz vorher löschen. Der kleinste löschbare Bereich ist allerdings ein ganzer Block.

In dem Block können nun Daten verschiedener Programme und Dokumente nebeneinanderliegen. Darauf zu warten, daß all diese Informationsschnipsel endgültig gelöscht werden dürfen, könnte sehr lange dauern, und sehr viel Platz wäre möglicherweise blockiert. In der Praxis wird also umsortiert: Die noch benötigten Daten werden an einen anderen Ort kopiert, dann wird der Block gelöscht, dann die Daten wieder zurückbefördert. Die LBA bzw. das Betriebssystem bekommt von diesen Vorgängen nichts mit. Die SSD führt also ein beachtliches Eigenleben.

2. Begrenzte Lebensdauer der Speicherzellen

Eine zweite Eigenschaft von SSDs ist beinahe noch problematischer.

Die Speicherzellen einer SSD haben einen relativ begrenzten Lebenszyklus. Nach einer gewissen Anzahl von Schreib-Lese-Vorgängen ist die Speicherzelle verbraucht. Dieser Zyklus wird zwar durch technische Verbesserungen nach und nach verlängert, aber die Begrenzung existiert und ist für alle Hersteller ein Problem. Normale Daten liegen vielleicht lange Zeit unverändert auf dem Volume herum, aber eine Systemdatei wird möglicherweise jede Sekunde gelesen, geändert oder zurückgeschrieben. Dann kann eine kritische Anzahl an Zugriffen vielleicht schon in einigen Wochen erreicht werden.

Aus diesem Grund hat jede SSD von vornherein immer etwas mehr Kapazität als draufsteht, damit der Anwender dem Sterben der Speicherzellen nicht direkt zusehen muß. Eine neue SSD hat z.B. eine Gesamtgröße von 512 GB – nächste Woche sind es nur noch 511 GB, nach einem Jahr noch 489 und so weiter. Die verlorengegangene Kapazität wird aus der Reserve nachgefüllt, so daß die Größe der SSD lange stabil bleibt.

Um das Problem der „sterbenden“ Speicherzellen in den Griff zu bekommen, reicht ein wenig Reservespeicher aber bei Weitem nicht aus. Es kommt vor allem darauf an, die Speicherzellen möglichst gleichmäßig abzunutzen – also werden die Daten auf der SSD permanent und gleichmäßig umgelagert. „Wear Leveling“ ist der Fachausdruck für dieses Verfahren, das alle Hersteller in leicht abgewandelten Varianten anwenden.

Zunächst werden die Daten bei einem Schreibvorgang so weit wie möglich verteilt. Genau dorthin, wo schon lange nichts mehr bewegt wurde und gleichzeitig genügend Platz frei ist. Maximale Fragmentierung der SSD ist sozusagen erste Pflicht des Controllers. Darüber hinaus ist die Steuerung der SSD ständig damit beschäftigt, Daten von viel benutzten Bereichen in andere, wenig genutzte Bereiche umzulagern.

Das einerseits sinnvoll – andererseits muß der Vorgang möglichst effizient sein, um nicht den Geschwindigkeitsvorsprung durch noch mehr Schreib- Lesevorgänge ad absurdum zu führen.

Insbesondere die Problematik der schwierigen Löschvorgänge in ganzen Blockgrößen verkompliziert das Ganze noch weiter. Hier kommen die in der SSD-Technik bekannten Ausdrücke „Garbage Collection“ und der vielzitierte Trim-Befehl zum tragen.

Garbage Collection

Eine SSD ist ein weitgehend autark agierendes System mit eigener „Intelligenz“, die das Verteilen und Umverteilen der Daten völlig unabhängig vom Betriebssystem erledigt. Ein Teil dieser internen Intelligenz wird „Garbage Collection“ (im Folgenden als GC abgekürzt) genannt. Die GC übernimmt einen Großteil der Daten-Umschichterei und ist auch dafür zuständig, möglichst ausreichend freien Speicher vorzuhalten. Daher auch der Name Garbage Collection (Müll-Sammlung).

Da die LBA nur dem Betriebssystem / Filesystem bekannt ist und die SSD keinen Zugriff darauf hat, muß die GC trickreich versuchen, vom Betriebssystem als gelöscht markierte Bereiche zu erkennen. Anfangs hat man dazu die FAT benutzt, was zwar nahelag, aber aus verschiedenen Gründen teils erheblich schiefgegangen ist. Heute ist die LBA der Master.

Registriert die GC, das das System einen Bereich überschreiben will, ist das für die GC die entscheidende Information. Die Daten werden dann nicht dort abgelegt, sondern optimal über die SSD verteilt. Die Schlußfolgerung: dieser File bzw. Bereich und dazugehörige Bereiche sind löschbar und können umorganisiert werden. Vor allem müssen diese Bereiche beim Umsortieren nicht mehr berücksichtigt werden, was Zeit und schädliche Schreib-Lesezugriffe einspart.

Eine GC kann dabei von Hersteller zu Hersteller sehr unterschiedlich arbeiten. Manche versuchen maximal viel freien Speicher vorzuhalten und nehmen dafür vermehrte Schreib-Lesezugriffen für das Datenschaufeln in Kauf. Andere sind konservativer und schichten nicht so aggressiv um. Allerdings kann ihnen gerade bei etwas bewegterem Datentransfer schon mal eher der freie, gelöschte Platz ausgehen – mit erheblichen Einbrüchen im Schreibtempo.

Eine nur über die Garbage Collection bereinigte Platte erfährt also erst durch einen Schreibbefehl, das der gerade adressierte Platz gelöscht werden kann. Vorher nimmt sie schon bestimmte Bereiche aus der Umschichtungsroutine heraus. Das endgültige „Go“, diesen Platz auch wirklich aufzuräumen, wird erst durch den Schreibbefehl des Betriebssystems ausgelöst.

Trim-Befehl

Hier kommt der Trim-Befehl ins Spiel, der diesen Vorgang enorm verkürzt. Er „spioniert“ sozusagen in der vom System geführten LBA-Datei herum und verrät die als „frei“ markierten Bereiche schon mal vorab an die GC. Eine gelöschte Datei wird ja nicht wirklich gelöscht, sondern nur in der LBA zum Überschreiben freigegeben – eben weil das ja zu Zeiten der HDD so war und immer noch ist. Löschen war ja nicht nötig.

Statt erst durch einen Schreibvorgang von freiem Speicher zu erfahren, weiß die GC das jetzt deutlich früher. Sie kann also darauf verzichten, große Speichermengen umzuschichten, und natürlich auch Speicherblöcke schneller wieder löschen und damit zur Verfügung stellen.

Unterm Strich: ein Garbage Collection benötigt man immer, aber eine GC arbeitet mit Trim-Unterstützung deutlich effektiver.

Unter der Plastikverkleidung ist also eine Menge los auf einer SSD, auch wenn sie eigentlich gerade nicht besonders gefordert wird. Dabei wird klar: ausreichend freier Platz ist, trotz eines völlig anderen internen Konzepts, für eine SSD noch wichtiger als für eine HDD.

Eine fast volle SSD kann intern kaum mehr effektiv umschichten, was zu immer häufigeren, aber uneffektiven Schreib/Lesevorgängen führen kann. Die SSD wird dann immer langsamer, altert viel schneller und ist eigentlich nur noch regenerierbar, indem man sämtliche Daten einmal komplett von der SSD entfernt, sie löscht und dann alles zurückkopiert. Unbestritten schnell und effektiv ist eine SSD vor allem bei einem durchschnittlichen User mit langsam wachsendem Datenvolumen. Einem Videoprofi mit extrem vielen, großen Datentransfers wird nun vielleicht auch einiges klarer…

Ebenfalls sollte deutlich geworden sein, warum ALLE !!!! Anbieter von Defragmentierungssoftware davon abraten, ihr Tool auf SSDs anzuwenden. Und nicht nur das: auch Geschwindigkeitstests mit massiven Dateitransfers oder viele Benchmarks sind absolut kontraproduktiv. Sie verringern nicht nur die Lebensdauer der SSD, sondern kosten zumindest eine Zeitlang auch Performance. Je voller die SSD ist, umso mehr.

Die vollkommen andere Funktionsweise einer SSD im Vergleich zur HDD wirft im Bereich der Betriebssysteme einige Fragen auf.

Mac OS X beispielsweise defragmentiert sein Startvolume aktiv – bei einer SSD eigentlich völlig falsch.

Was ist mit der Lagerung oft benutzter Daten im Hotband, wenn da keine HDD, sondern eine SSD arbeitet ? Eigentlich das verkehrteste, was man tun kann – darüberhinaus müht sich OS X völlig überflüssigerweise, oft benötigte Daten in den schnellen Bereich einer nicht vorhandene Platte zu kopieren.

Bei Mac Books wird der Inhalt des Arbeitsspeichers bei jedem Zuklappen auf das Startvolume geschrieben (Hibernating) – wäre nicht eigentlich das alte Verfahren, den Arbeitsspeicher weiter zu Puffern, bei Verwendung einer SSD viel vorteilhafter ?

Die Mac-Programme zum aktivieren der Trim-Funktion (z.B. der Trim Enabler von Cindori Software, dazu siehe auch weiter unten) bringen aus diesem Grund weitere sinnvolle Einstellmöglichkeiten mit. Dazu zählen unter anderem das Deaktivieren von Snapshots beim Zuklappen von Books, Deaktivieren von Time Machine Snapshots und Sleep Mode der Platte, Weglassen des sogenannten Notime Flags, das bei jedem Zugriff auf eine Datei einen Timestamp hinterlässt, und das bei einer SSD völlig unnötige Sudden Motion Verhalten bei HDDs.

Diese Liste ließe sich noch deutlich erweitern, und man könnte mit Schmankerln aus anderen Betriebssystemen für Heiterkeit sorgen. Unterm Strich bleibt aber etwas anderes:

SSDs haben aufgrund ihres hohen Tempos unbestreitbare Vorteile, insbesondere dann, wenn Sie die Enge des S-ATA-Korsetts verlassen wie bei den aktuellen Books und dem Mac Pro.

Aber ebenso wie erst das Verlassen des S-ATA-Anschlusses das volle Tempo ermöglichte, muß auch über die unsinnig gewordenen Schnittstelle neu nachgedacht werden. Selbst für aktuelle HDDs sind die vielen uralten Konventionen unsinnig und einschränkend. SSDs arbeiten sogar völlig anders, als das Betriebssystem / Filesystem annimmt bzw. vorsieht. Die etwas neutralere LBA ermöglicht zwar die Arbeit mit der SSD, aber warum ist sie von Seiten der SSD nicht einfach lesbar ?

Ein kleines Beispiel: Legt man auf einer SSD eine sehr große Datei wie z.B. einen Film ab, wird die Datei auf viele verschiedene Pages verteilt, zusammen mit anderen Datenfragmenten. Wird der Film anschließend wieder gelöscht, bricht auf der SSD das Chaos aus, da überall Teile des Films zusammen mit andern Daten in sehr vielen verschiedenen Pages liegen.

Würde das Betriebssystem schon vorher sagen: „Achtung ! Da kommen große zusammengehörige Datenmengen !“, könnte das System versuchen, diese Daten auf komplett leere Pages zu legen. Beim Löschen entfiele dadurch das im vorherigen Szenario notwendige Umschichten von noch benutzten Dateien. Der Löschvorgang könnte ungleich viel schneller und effektiver ablaufen. Das würde zwar deutlich mehr freien Platz erfordern, aber die SSD videotauglicher machen.

Ebenfalls unsinnig ist der Befehl, eine Datei wirklich zu löschen, also mit Bitmustern zu überschreiben. Denn die Daten liegen ohnehin schon längst nicht mehr da, wo das Betriebssystem sie erwartet. Zwischendurch wurden die Daten vielleicht schon mehrmals umgeschichtet, aber dennoch bleiben die Schnipsel an den alten Ablageorten weiter liegen, bis der Block irgendwann gelöscht wird. Dieser Effekt macht es auf der anderen Seite den Recovery-Programmen so schwer, die richtigen, aktiven Datenschnipsel auf einer defekten SSD zu identifizieren.

So etwas kann natürlich nur funktionieren, wenn das Speichermedium und das Betriebssystem wieder mehr voneinander wissen. Das war früher schon so, und es war effektiv und gut. Das heutige komplette Abschotten dieser beiden Bestandteile und dazu die Beibehaltung von steinzeitlichen Konventionen, die nichts mehr mit der Realität zu tun haben, ist eigentlich nur ein fauler Kompromiß und erfordert dringend ein deutliches Umdenken – eigentlich Dinge, die wir gerade von Apple als Vorreiter erwarten würden.

Ich bin sicher, daß genau in diesem Bereich der Zusammenarbeit zwischen Betriebssystem, modernem Filesystem und Datenspeicher sehr viel Entwicklungspotential liegt. Im entwicklungsfreundlichen Linux-Umfeld sind schon erste, auf SSDs abgestimmte Dateisysteme entstanden.

– SSDs brauchen aktive Erholungszeiten. Es ist also empfehlenswert, den Rechner abends nach eventuellen Löschvorgängen nicht sofort auszuschalten oder in den Ruhezustand zu versetzen. Etwas Zeit im Leerlauf ermöglicht der SSD, ordentlich aufzuräumen.

– Poweruser mit vielen Datentransfers sollten Löschvorgänge nicht zu sehr hinauszögern. Anders als eine HDD profitiert eine SSD davon.

– Unbedingt ausreichend freien Platz vorhalten. Für Poweruser sollten 30% ein guter Wert sein.

Die im Artikel angesprochenen Software Trim Enabler kann (aber mit Vorsicht) auch unter OS X 10.10 eingesetzt werden.

Die Software installiert bzw. modifiziert Systemtreiber, um die Trim Funktionalität zu ermöglichen. Das war bis einschließlich 10.9 auch ohne Weiteres möglich.

Im Rahmen erweiterter Bemühungen um mehr Sicherheit hat Apple allerdings diese Möglichkeit pauschal geblockt.

Nur die aktuellste Version von Trim Enabler kann installiert werden. Dazu muß allerdings die neue Sicherheitseinschränkung deaktiviert werden – und zwar nicht nur für den Trim Enabler, sondern komplett. Die Software erledigt das während der Installation. Jeder Anwender muß für sich abwägen, ob er das möchte. Es geht „nur“ um erweiterte Sicherheitsfunktionen, die es bis einschließlich 10.9 nicht gab.

Noch etwas gilt es zu beachten: Wenn Trim Enabler (oder eine andere Software) auf diesem Weg installiert wird, wird der Rechner nach jedem Zurücksetzen des NVRAMs mit einem grauen Bildschirm mit Halteverbotszeichen die Arbeit verweigern ! Durch einen Start im Recovery-Modus und einer Menge Terminalbefehle läßt sich der Mac wieder zum Leben erwecken. Dazu sollte man aber diese Anleitung unbedingt ausgedruckt vorliegen haben.

(b734/hr)

Endlich mal ein Artikel der sich etwas differenzierter mit der SSD beschäftigt und deren Besonderheiten erklärt.

Vielen Dank

Danke für die Blumen :-)

Vielen Dank für diesen lehrreichen Beitrag!

Kann ich dem anderen Daniel nur zustimmen – Einiges über SSDs gelernt. :-)

Was ich seltsam finde, die neuen Mac Books werden jetzt schon mit SSD´s ausgeliefert, oder?

Wundert mich dann, dass Yosemite nicht anders auf SSD´s reagiert – auch das sie dann noch keine integrierten Trim-Funktion besitzt.

…aber da SSD´s wohl für das Startvolumen irgendwann Standard werden, sollte das irgendwann Bestandteil des OS werden, oder was meint ihr.

Hallo Daniel,

soweit wir wissen, benutzt Apple durchaus den Trim-Befehl. Vielleicht ja intern auch noch weitere Funktionen. Leider ist das nicht wirklich dokumentiert. Ohne Trim-Befehl würden auch die von Apple verbauten SSDs an Performance verlieren.

Apple hat die Funktionen vermutlich ausschließlich für die von ihnen selbst verbauten SSDs freigeschaltet. Alle ThirdParty Produkte bleiben außen vor. Möglicherweise hat das einen technischen Hintergrund, den wir aber leider nicht kennen und daher auch nicht beurteilen können.

Grüße :-) Heinrich

Vielen Dank für Euren Beitrag zur SSD, sehr schön differenziert.

Für mich stellt sich nun eine Frage: Ist es sinnvoll mein MBP 3.1, was derzeit mit OS 10.6.8 läuft, mit einer SSD zu modernisieren ? Wenn ja, welche Größe ? Derzeit habe ich 125 GB, wovon mindestens 100 GB belegt sind. Es muß eine neue Festplatte demnächst sein. Aufgrund meiner vielen Photos dachte ich an wenigstens 250 GB.

Liebe Grüße

Andrea

Hallo Andrea,

Dein MacBook Pro 3.1 hat einen relativ alten S-ATA Anschluß.

Das bedeutet leider, das eine SSD absolut keinen Sinn macht, denn etwa bei 120 MB/s ist da eine feste Grenze durch den alten S-ATA Anschluß.

Und den Wert schafft auch eine gute herkömmliche Platte.

Das hat aber auch ein Gutes: Die Aufrüstung deines Books wird deutlich günstiger und auch mit mehr Speicherplatz als geplant.

Platten unter 500 GB gibt es ja kaum noch zu kaufen, und eine moderne Platte wird das Book dennoch deutlich schneller machen.

Die Modelle mit 7200 U/min sind merkbar schneller, aber etwas lauter, die mit 5400 U/min etwas leiser und günstiger, aber immer noch deutlich schneller als deine vorhandene Platte.

Und wenn du schon dabei bist: Bitte unbedingt die jeweils 3 Schrauben der Lüfter lösen und die Lüfter herausnehmen.

Dann unbedingt das Gitter, durch das die Lüfter blasen, reinigen (absaugen).

Viele Grüße,

Heinrich

Vielen für Eure Antwort zum Sonntag !! Ich werde den Plattenwechsel nicht selber machen; ich hoffe, meine Werkstatt denkt an die Lüfter, wenn ich es extra dazu sage …

Danke, Andrea

Vor ein paar Jahren habe ich das DVD Laufwerk meines MacBookPro6,2 (8G Ram) durch eine 160GB INTEL SSDSA2M160G2GC ersetzt auf der OSX Yosemite und mein User Account liegen. Diese „Platte“ ist obendendrein noch eine verschlüsselte logische Partition und hat typischerweise nur noch 5-10GB frei. Die Hauptdatenmenge liegt auch der zweiten internen 1TB Platte.

Nachdem ich über den Wechsel auf eine größere SSD nachgedacht habe bin ich auf euren Artikel gestossen und nun gar nicht mehr so sicher, dass ich mein System ideal aufgesetzt habe.

Fakt ist, die 160G als „Systemplatte“ schaffen mir immer wieder mehr Arbeit, als sie mir ersparen. Und da ich mein MacBook nahezu ausschliesslich am Schreibtisch mit externem Monitor & Zubehör verwende, sollte ich mich vermutlich auch von der Apple-internen Verschlüsselung der SSD verabschieden, oder?

Fakt ist auch, dass meine permanent volle SSD allein schon durch email und ihre Funktion als „Ablage“ = Desktop immer ordentlich zu tun hat – ganz zu schweigen, von den lästigen „Auslagerungen“ auf die 1TB Platte, wenn es auf der SSD mal wieder zu voll geworden ist.

Und ja, wie man das von laptops kennt, klicke ich abends nach getaner Arbeit im Menü auf „Ruhezustand“, bis ich meinen mac morgens wieder aufwecke …

Was wären eure Empfehlungen für einen „solchen User“, der mehr Platz braucht?

– über S-links den ganzen User inkl. library und Desktop auf die 1TB HDD auslagern und damit mehr Platz auf SSD fürs System garantieren?

– oder alles lasen wie bisher und nur die SSD gegen eine Größere tauschen auf der immer 10-15% Platz frei sind?

– oder lieber ganz von der 1TB HDD booten und die SSD für Spezialfälle nutzen? Welche auch immer …

– die Verschlüsselung raus nehmen oder ändert das kaum was an Performance?

Ich freu mich über eure Unterstützung, Anregungen und Tips und sag‘ schonmal Danke dafür :-)

Klaus

Hallo Klaus,

mal der Reihe nach: Deine Platte ist verschlüsselt, ich denke mal mit FileVault.

FileVault ist schon sehr gut programmiert und benutzt Hardwareroutinen. Daher ist der Geschwindigkeitsverlust vergleichsweise klein. Aber wenn man es nicht benötigt, gibt es auch keinen Grund es einzuschalten.

Aber nun zu deiner eigentlichen Frage: Eine SSD ist heute immer merkbar schneller als eine „normale“ Festplatte. Das merkt man schon, auch wenn normale Festplatten auch immer schneller geworden sind. Auch die aktuellen „langsamen“ 5400 U/min Modelle einiger Hersteller haben heute so große Cache Files, das viele Operationen aus diesem Cache heraus ausgeführt werden. In der Regel laufen diese Platten als Hybrid-Platten im Sortiment.

Zumindest erreichen diese leisen 5400er Platten das Tempo der schneller drehenden 7200 U/min Platten.

Einige Hersteller haben daher die Produktion der hoch drehenden Modelle schon eingestellt.

Wäre dein Book noch etwas jünger, wäre unsere Empfehlung klar: Auch eine größere SSD ist heute bezahlbar und der Tempozuwachs ist enorm.

Dein Book hat aber noch eine 3 Gbit/s Schnittstelle an beiden Ports, also ist in der Praxis bei Werten von etwa 250 MB/sec sowieso die Grenze erreicht. Den Geschwindigkeitsvorteil einer aktuellen SSD mit Werten oberhalb von 500 kann die verbaute Schnittstelle nicht realisieren.

Auch eine schnelle Platte wird deutlich darunter liegen, aber eben nicht so enorm wie bei einem moderneren Book.

Was aber gar keinen Spass macht, ist das ständige, manuelle Umlagern von Daten. Davon sollte man schnell wegkommen.

Folgende Möglichkeiten:

1. Eine vernünftige und ausreichend große SSD. Wenn du mit 500 GB hinkommst, wäre das unsere Empfehlung. Bei einer Terabyte Variante schreckt dann doch der Preis.

2. Wenn die benötigte Datenmenge im Bereich bis 700 GB liegt, kommt eine 1 TB Hybrid Platte in Frage – oder die Variante 3:

3. Zwei „normale“ (nicht Hybrid) 1 TB Platten als Raid 0. Macht 2 TB Nutzdaten mit einem fast einer SSD in deinem Book entsprechenden Tempo. Im Gegenzug Platz ohne Ende und ein vertretbarer Preis.

Aber da bei einem Plattenausfall nur einer Platte alle Daten verloren sind, ist hierbei eine gute und gepflegte Datensicherung zwingend. Auch die Akkulaufzeit ist bei dieses Variante etwas kürzer.

Die Variante 3 finden wir bei größerem Datenvolumen und Deinem Book schon sehr elegant.

Viele Grüße,

Heinrich

Hallo tiramigoof,

danke für den sehr guten Artikel. Eine Verständnisfrage plagt mich noch. Dass die SSDs mit der Zeit ihre Kapazität einbüßen, da die Speicherzellen abgeschaltet werden ist klar. Aber besteht dadurch nicht auch das Risiko des Datenverlusts? Merken die SSDs also selbständig, wann die Daten umgeschichtet werden müssen und machen sie das rechtzeitig? Was passiert, wenn kein freier Speicher übrig ist und dann Speicherbereiche gesperrt werden müssen – gibt es Warnmechanismen?

Zwar mache ich regelmäßig Backups über TimeMachine und eine externe Platte, aber sobald die originalen Daten beschädigt wurden, werden sie auch beschädigt gesichert. Zumindest wenn man sie komplett ersetzt und kein inkrementelles Backup macht.

Können meine Daten also unbemerkt korrumpiert werden, ohne dass ich es merke oder etwas dagegen tun kann?

Danke für eure Einschätzung,

viele Grüße

Chris

Danke, sehr Interessant.

Endlich mal ein Artikel der sich etwas differenzierter mit der SSD beschäftigt und deren Besonderheiten erklärt.

Vielen Dank